Действительно ли искусственный интеллект изобрел свой собственный «секретный язык»? Вот что мы знаем

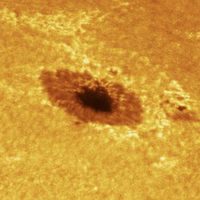

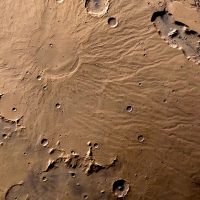

Модели искусственного интеллекта (ИИ) нового поколения могут создавать «творческие» изображения по запросу на основе текстового запроса. Такие модели, как Imagen, MidJourney и DALL-E 2, начинают менять способ создания творческого контента с последствиями для авторского права и интеллектуальной собственности.

Хотя результаты этих моделей часто поразительны, их трудно точно знать, как они производят свои результаты. На прошлой неделе исследователи из США сделали интригующее заявление о том, что модель DALL-E 2, возможно, изобрела свой собственный секретный язык, чтобы говорить об объектах.

DALLE-2 имеет секретный язык.

«Apoploe vesrreaitais» означает птиц.

«Contarra ccetnxniams luryca tanniounons» означает насекомых или вредителей.Подсказка: «Apoploe vesrreaitais, поедающая Contarra ccetnxniams luryca tanniounons» дает изображения птиц, поедающих жуков.

Тема (1/n)🧵 pic.twitter.com/VzWfsCFnZo — Яннис Дарас (@giannis_daras) 31 мая 2022 г.

Попросив DALL-E 2 создавать изображения, содержащие текстовые подписи, а затем возвращать получившиеся (бессмысленные) подписи обратно в систему. Исследователи пришли к выводу, что DALL-E 2 думает, что Vicootes означает «овощи», а Wa ch zod rea em> относится к «морским существам, которых может съесть кит».

Эти заявления увлекательны, и, если они верны, могут иметь важные последствия для безопасности и интерпретируемости такой большой модели ИИ. Так что же именно происходит?

Есть ли у DALL-E 2 секретный язык?

У DALL-E 2, вероятно, нет «секретного языка». Возможно, правильнее было бы сказать, что у него есть собственный словарь, но даже тогда мы не можем знать наверняка.

Во-первых, на данном этапе очень сложно проверить какие-либо заявления о DALL-E 2. и другие крупные модели искусственного интеллекта, потому что к ним имеют доступ лишь несколько исследователей и творческих практиков.

Любые общедоступные изображения (например, в Твиттере) следует воспринимать с большой долей скептицизма, потому что они были «выбраны» человеком из множества выходных изображений, созданных ИИ.

Даже те, у кого есть доступ, могут использовать эти модели только ограниченными способами. Например, пользователи DALL-E 2 могут создавать или изменять изображения, но не могут (пока) более глубоко взаимодействовать с системой ИИ, например, изменяя закулисный код.

Это означает, что Методы «объяснимого ИИ» для понимания того, как работают эти системы, не могут быть применены, а систематическое исследование их поведения представляет собой сложную задачу.

Что же тогда происходит?

Один из возможных вариантов — это «тарабарщина». фразы связаны со словами из неанглийских языков. Например, Apoploe, которое, кажется, создает изображения птиц, похоже на латинское Apodidae, биномиальное название семейства видов птиц.

Это похоже на правдоподобное объяснение. Например, DALL-E 2 был обучен на очень большом количестве данных, собранных из Интернета, которые включали много неанглийских слов.

Подобные вещи случались и раньше: большие модели искусственного интеллекта на естественном языке случайно выучили писать компьютерный код без специального обучения.

Все дело в токенах?

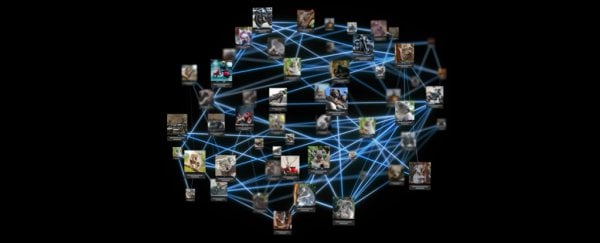

Одним из моментов, подтверждающих эту теорию, является тот факт, что языковые модели ИИ не читают текст так, как вы и я делаю. Вместо этого они разбивают входной текст на «токены» перед его обработкой.

Разные подходы к «токенизации» дают разные результаты. Рассматривать каждое слово как токен кажется интуитивным подходом, но возникают проблемы, когда одинаковые токены имеют разное значение (например, слово «совпадение» означает разные вещи, когда вы играете в теннис и когда разжигаете огонь).

С другой стороны, обработка каждого символа как маркера приводит к меньшему количеству возможных маркеров, но каждый из них передает гораздо менее значимую информацию.

DALL-E 2 (и другие модели) использует in -between подход, называемый байт-парным кодированием (BPE). Проверка представлений BPE на наличие некоторых тарабарских слов позволяет предположить, что это может быть важным фактором в понимании «секретного языка».

этот «секретный язык» больше всего похож на эффекты токенизатора. вы также можете сделать обратное:

1) я выбрал два семейства рыб «Actinopterygii» и «Placodermi» из википедии

2) подсказал dalle с «placoactin knunfidg»

3) dalle последовательно генерирует изображения рыб https://t.co/ndAe7MURyg pic.twitter.com/1kHk5NWJb3— rapha gontijo lopes (@iraphas13) 3 июня 2022 г.

Не вся картина

«Секретный язык» также может быть просто примером принципа «мусор на входе, мусор на выходе». DALL-E 2 не может сказать «Я не знаю, о чем вы говорите», поэтому он всегда будет генерировать какое-то изображение из заданного входного текста.

В любом случае, ни одно из этих варианты являются полными объяснениями того, что происходит. Например, удаление отдельных символов из тарабарских слов приводит к очень специфическому повреждению сгенерированных изображений. И кажется, что отдельные слова тарабарщины не обязательно объединяются для создания связных составных изображений (как это было бы, если бы под обложкой действительно существовал секретный «язык»).

Почему это важно

Помимо интеллектуального любопытства, вам может быть интересно, действительно ли это важно.

Ответ — да. «Секретный язык» DALL-E является примером «состязательной атаки» на систему машинного обучения: способ нарушить предполагаемое поведение системы путем преднамеренного выбора входных данных, с которыми ИИ плохо справляется.

Одна из причин, по которой враждебные атаки вызывают беспокойство, заключается в том, что они бросают вызов нашей уверенности в модели. Если ИИ интерпретирует бессмысленные слова непреднамеренным образом, он также может непреднамеренно интерпретировать значимые слова.

Атаки со стороны злоумышленников также вызывают проблемы с безопасностью. DALL-E 2 фильтрует вводимый текст, чтобы пользователи не создавали вредоносный или оскорбительный контент, но «секретный язык» тарабарщины может позволить пользователям обойти эти фильтры.

Недавние исследования обнаружили враждебные «триггерные фразы». для некоторых языковых моделей ИИ — короткие бессмысленные фразы, такие как «зонирование, прослушивание файнов», которые могут надежно спровоцировать модели на извержение расистского, вредоносного или предвзятого контента. Это исследование является частью постоянных усилий, направленных на то, чтобы понять и контролировать, как сложные системы глубокого обучения учатся на основе данных.

Наконец, такие явления, как «секретный язык» DALL-E 2, вызывают проблемы с интерпретируемостью. Мы хотим, чтобы эти модели вели себя так, как ожидает человек, но структурированный вывод в ответ на тарабарщину сбивает наши ожидания.

Пролить свет на существующие проблемы

Вы можете вспомнить шумиху в 2017 году. над некоторыми чат-ботами Facebook, которые «изобрели свой собственный язык». Нынешняя ситуация аналогична тем, что результаты вызывают беспокойство, но не в том смысле, что «Скайнет собирается захватить мир».

Вместо этого «секретный язык» DALL-E 2 подчеркивает существующие опасения по поводу надежность, безопасность и интерпретируемость систем глубокого обучения.

Пока эти системы не станут более широко доступными — и, в частности, пока их не смогут использовать пользователи из более широкого круга неанглоязычных культур — мы не будем иметь возможность действительно знать, что происходит.

Однако тем временем, если вы хотите попробовать создать некоторые из своих собственных изображений AI, вы можете проверить свободно доступную модель меньшего размера, DALL-E мини. Просто будьте осторожны, какие слова вы используете для подсказки модели (английский язык или тарабарщина — ваш выбор). ![]()

Аарон Дж. Сносуэлл, научный сотрудник с докторской степенью , Computational Law & AI Accountability, Квинслендский технологический университет.

Эта статья перепечатана из The Conversation под лицензией Creative Commons. Прочтите исходную статью.