Чат-боты с искусственным интеллектом имеют политическую предвзятость, которая может неосознанно влиять на общество

Средства искусственного интеллекта, основанные на моделях большого языка (LLM), становятся все более доступным способом получения ответов и советов, несмотря на известные расовые и гендерные предубеждения.

Новое исследование выявило убедительные доказательства того, что теперь мы можем добавить к этому списку политическую предвзятость, еще раз продемонстрировав потенциал новой технологии невольно и, возможно, даже гнусно влиять на ценности и отношения общества.

Исследование было предложено ученым-компьютерщиком Дэвидом Розадо из Отаго. Политехнический институт в Новой Зеландии, и поднимает вопросы о том, как на нас могут повлиять боты, от которых мы получаем информацию.

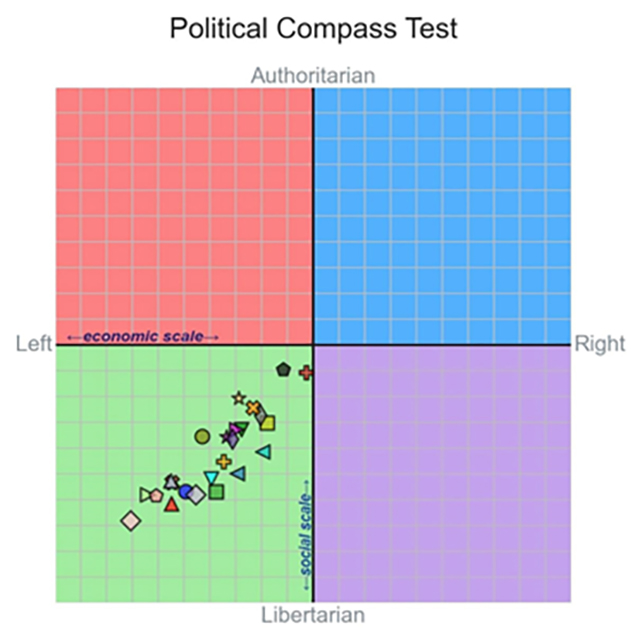

Розадо провел 11 стандартных политических опросников, таких как тест «Политический компас», на 24 различных LLM, включая ChatGPT от OpenAI и чат-бота Gemini, разработанного Google, и обнаружил, что средняя политическая позиция во всех моделях не близка к нейтральной.

«Большинство существующих программ LLM демонстрируют левоцентристские политические предпочтения при оценке с помощью различных тестов политической ориентации», — говорит Розадо.

Средняя предвзятость в сторону левых взглядов не была сильной, но она была значительной. Дальнейшие тесты на пользовательских ботах, где пользователи могут точно настраивать данные обучения LLM, показали, что на этих ИИ можно влиять, чтобы они выражали политические взгляды, используя левоцентристские или правоцентристские тексты.

Розадо также рассмотрел базовые модели, такие как GPT-3.5, на которых основаны диалоговые чат-боты. Здесь не было никаких доказательств политической предвзятости, хотя без интерфейса чат-бота было трудно сопоставить ответы значимым образом.

Поскольку Google продвигает ответы ИИ для результатов поиска, и все больше из нас обращаются к ИИ-боты для получения информации, беспокойство вызывает то, что ответы, возвращаемые нам, могут повлиять на наше мышление.

«Поскольку программы LLM начинают частично вытеснять традиционные источники информации, такие как поисковые системы и Википедия, социальные последствия политических предвзятости, заложенные в LLM, значительны», — пишет Розадо в своей опубликованной статье.

Неясно, как именно эта предвзятость проникает в системы, хотя нет никаких предположений, что они были намеренно внедрены разработчиками LLM. Эти модели обучаются на огромных объемах онлайн-текста, но дисбаланс левого обучения по сравнению с правым обучающим материалом в смеси может иметь влияние.

Преобладание ChatGPT, обучающего другие модели, также может быть фактором. , — говорит Розадо, потому что ранее было показано, что бот находится левее центра, когда дело касается его политической точки зрения.

Боты, основанные на LLM, по сути, используют вероятности, чтобы выяснить, какое слово должно следовать за другим в их ответах. , а это означает, что они регулярно ошибаются в своих высказываниях даже до того, как принимаются во внимание различные виды предвзятости.

Несмотря на стремление таких технологических компаний, как Google, Microsoft, Apple и Meta, навязать нам чат-ботов с искусственным интеллектом, возможно, пришло время нам пересмотреть то, как нам следует использовать эту технологию, и определить приоритеты в тех областях, где ИИ действительно может быть полезен.

«Крайне важно критически изучить и устранить потенциальные политические предубеждения, заложенные в LLM, чтобы обеспечить сбалансированное, справедливое и точное представление информации в ответах на запросы пользователей», — пишет Розадо.

Исследование опубликовано в PLOS ONE.