Существует тревожная расовая предвзятость в том, насколько хорошо ИИ-лица могут нас обмануть

Вызывает ли ChatGPT когда-нибудь жуткое ощущение, что вы взаимодействуете с другим человеком?

Искусственный интеллект (ИИ) достиг поразительного уровня реализма, до такой степени, что некоторые инструменты могут даже обмануть людей думать, что они взаимодействуют с другим человеком.

На этом жутковатость не заканчивается. В исследовании, опубликованном сегодня в журнале Psychological Science, мы обнаружили, что изображения белых лиц, созданные с помощью популярного алгоритма StyleGAN2, выглядят более «человечными», чем лица реальных людей.

ИИ создает гиперреалистичные изображения. лица

Для нашего исследования мы показали 124 участникам фотографии множества разных белых лиц и попросили их решить, было ли каждое лицо реальным или создано искусственным интеллектом.

Половина изображений была реальной. лица, а половина была создана искусственным интеллектом. Если бы участники угадали случайным образом, мы бы ожидали, что они будут правы примерно в половине случаев — это похоже на подбрасывание монеты и в половине случаев выпадение решки.

Вместо этого участники систематически ошибались и с большей вероятностью ошибались. говорят, что лица, сгенерированные ИИ, были реальными. В среднем люди помечали около 2 из 3 лиц, сгенерированных ИИ, как человеческие.

Эти результаты показывают, что лица, сгенерированные ИИ, выглядят более реальными, чем реальные лица; мы называем этот эффект «гиперреализмом». Они также предполагают, что люди в среднем не очень хорошо умеют распознавать лица, созданные ИИ. Вы можете сами сравнить портреты реальных людей вверху страницы с теми, что размещены ниже.

Но, возможно, люди осознают свои ограничения и поэтому вряд ли станут жертвами ИИ. -генерируемые лица в Интернете?

Чтобы выяснить это, мы спросили участников, насколько они уверены в своих решениях. Парадоксально, но люди, которые хуже всего распознавали самозванцев с помощью ИИ, были наиболее уверены в своих догадках.

Другими словами, люди, которые были наиболее подвержены обману с помощью ИИ, даже не подозревали, что их обманывают. обманут.

Просмотреть это сообщение в Instagram

Сообщение, опубликованное пользователем UnReal Person (@person.unreal)

Смещенные данные обучения дают необъективные результаты h2>

Четвертая промышленная революция, включающая в себя такие технологии, как искусственный интеллект, робототехника и передовые вычисления, глубоко изменила виды «лиц», которые мы видим в Интернете.

Лица, созданные с помощью искусственного интеллекта, легко доступны, и их использование сопряжено как с риском, так и с пользой. Хотя их использовали для поиска пропавших детей, их также использовали для мошенничества с личными данными, ловли кошек и кибервойны.

Неоправданная уверенность людей в их способности обнаруживать Лица ИИ могут сделать их более восприимчивыми к мошенническим действиям. Например, они могут легко передать конфиденциальную информацию киберпреступникам, маскирующимся под гиперреалистичные личности ИИ.

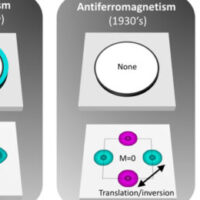

Еще одним тревожным аспектом гиперреализма ИИ является его расовая предвзятость. По данным другого исследования, в котором также проверялись азиатские и чернокожие лица, мы обнаружили, что только белые лица, созданные ИИ, выглядели гиперреальными.

Когда участников попросили решить, были ли цветные лица человеческими или сгенерированными ИИ, примерно половина участников угадали правильно. время – это похоже на случайное угадывание.

Это означает, что белые лица, сгенерированные ИИ, выглядят более реальными, чем цветные лица, сгенерированные ИИ, а также белые человеческие лица.

Последствия предвзятости и гиперреалистичный ИИ

Эта расовая предвзятость, вероятно, связана с тем фактом, что алгоритмы ИИ, включая тот, который мы тестировали, часто обучаются на изображениях преимущественно белых лиц.

Расовая предвзятость в алгоритмическом обучении может иметь серьезные последствия. Одно недавнее исследование показало, что беспилотные автомобили с меньшей вероятностью обнаруживают чернокожих, что подвергает их большему риску, чем белых. И компании, производящие ИИ, и контролирующие их правительства несут ответственность за обеспечение разнообразного представительства и смягчение предвзятости в ИИ.

Реалистичность контента, создаваемого ИИ, также поднимает вопросы о нашей способности точно обнаружить его и защитите себя.

В ходе нашего исследования мы выявили несколько особенностей, благодаря которым белые лица ИИ выглядят гиперреальными. Например, у них часто пропорциональные и знакомые черты лица, но им не хватает отличительных характеристик, которые выделяли бы их «странными» среди других лиц. Участники ошибочно истолковали эти особенности как признаки «человечности», что привело к эффекту гиперреализма.

В то же время технология искусственного интеллекта развивается настолько быстро, что будет интересно посмотреть, как долго будут применяться эти выводы. Также нет никакой гарантии, что лица ИИ, созданные другими алгоритмами, будут отличаться от человеческих лиц так же, как те, которые мы тестировали.

После публикации нашего исследования мы также проверили способность технологии обнаружения ИИ идентифицировать наши Лица ИИ. Хотя эта технология утверждает, что идентифицирует конкретный тип лиц ИИ, которые мы использовали, с высокой точностью, она работала так же плохо, как и наши участники-люди.

Аналогично, программное обеспечение для обнаружения написанного ИИ также имеет высокий уровень ложных обвинений. люди, которые жульничают, особенно люди, чей родной язык не английский.

Управление рисками, связанными с ИИ

Так как же люди могут защитить себя от ошибочного признания контента, созданного ИИ, реальным?

Один из способов — просто осознавать, насколько плохо люди справляются с задачей отделения лиц, созданных ИИ, от реальных. Если мы будем более осторожно относиться к нашим собственным ограничениям на этом фронте, на нас будет труднее влиять то, что мы видим в Интернете, и мы сможем предпринять дополнительные шаги для проверки информации, когда это важно.

Государственная политика также играет важную роль. роль. Один из вариантов — потребовать декларировать использование ИИ. Однако это может не помочь или может непреднамеренно создать ложное чувство безопасности, когда ИИ используется в обманных целях – и в этом случае его практически невозможно контролировать.

Другой подход заключается в том, чтобы сосредоточиться на проверке подлинности доверенных источников. . Подобно маркировке «Сделано в Австралии» или «Европейской маркировке CE», применение значка доверенного источника, который можно проверить и получить путем строгих проверок, может помочь пользователям выбирать надежные носители.![]()

Эми Доуэл, клинический психолог и преподаватель Исследовательской школы психологии Австралийского национального университета; Бен Альберт Стюард, Австралийский национальный университет; Клэр Сазерленд, старший преподаватель Абердинского университета; Ева Крумхубер, доцент UCL, и Захари Витковер, доцент Амстердамского университета

Эта статья переиздана из The Conversation под лицензией Creative Commons. Прочтите оригинал статьи.