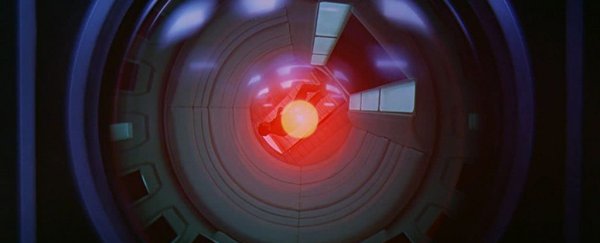

Исследователи говорят, что управлять сверхинтеллектуальным ИИ будет невозможно

Идея свержения человечества искусственным интеллектом обсуждалась на протяжении десятилетий, и в 2021 году ученые вынесли вердикт о том, сможем ли мы управлять высокоуровневым компьютерным сверхразумом. Ответ? Почти наверняка нет.

Загвоздка в том, что для управления сверхразумом, находящимся далеко за пределами человеческого понимания, потребуется симуляция этого сверхразума, которую мы можем анализировать (и контролировать). Но если мы не в состоянии это понять, создать такую симуляцию невозможно.

Невозможно установить такие правила, как «не причинять вреда людям», если мы не понимаем, что такое сценарии что ИИ собирается придумать, предполагают авторы новой статьи. Как только компьютерная система работает на уровне, превышающем возможности наших программистов, мы больше не можем устанавливать ограничения.

«Сверхразум ставит принципиально иную проблему, чем те, которые обычно изучаются под лозунгом «роботизирования». этика», — написали исследователи.

«Это связано с тем, что сверхразум многогранен и, следовательно, потенциально способен мобилизовать разнообразные ресурсы для достижения целей, потенциально непостижимых для людей, не говоря уже о поддается контролю.»

Часть рассуждений команды исходит из проблемы остановки, сформулированной Аланом Тьюрингом в 1936 году. Проблема заключается в том, чтобы узнать, придет ли компьютерная программа к выводу и ответу (поэтому она останавливается) , или просто зацикливаться, пытаясь найти его.

Как доказал Тьюринг с помощью хитрой математики, хотя мы можем знать, что для некоторых конкретных программ логически невозможно найти способ, который позволит нам узнать это для каждая потенциальная программа, которая когда-либо могла быть написана. Это возвращает нас к ИИ, который в сверхразумном состоянии мог бы одновременно удерживать в своей памяти все возможные компьютерные программы.

Любая программа, написанная для того, чтобы не дать ИИ причинить вред людям и уничтожить мир, например. , может прийти к заключению (и остановиться) или нет — математически невозможно для нас быть абсолютно уверенным в любом случае, что означает, что его невозможно сдержать.

«По сути, это делает алгоритм сдерживания непригодным для использования», — сказал ученый-компьютерщик Ияд Рахван из Института человеческого развития им. Макса Планка в Германии в 2021 году.

Альтернатива обучению ИИ некоторым этическим нормам и указанию ему не разрушать мир — то, в чем ни один алгоритм не может быть абсолютно уверен. Делать, говорят исследователи, — это ограничивать возможности сверхразума. Например, он может быть отрезан от частей Интернета или определенных сетей.

Исследование отвергло и эту идею, предполагая, что это ограничит возможности искусственного интеллекта; аргумент состоит в том, что если мы не собираемся использовать его для решения проблем, выходящих за рамки человеческих возможностей, то зачем вообще его создавать?

Если мы собираемся продвигать искусственный интеллект, мы, возможно, не даже знать, когда прибывает сверхразум, неподвластный нашему контролю, такова его непостижимость. Это означает, что нам нужно начать задавать серьезные вопросы о том, в каком направлении мы движемся.

«Сверхразумная машина, управляющая миром, звучит как научная фантастика», – сказал ученый-компьютерщик Мануэль Себриан из компании Max. -Planck Institute for Human Development, также в 2021 году. «Но уже есть машины, которые выполняют определенные важные задачи независимо, без полного понимания программистами того, как они этому научились».

«Поэтому возникает вопрос, могло ли это когда-нибудь точка станет неконтролируемой и опасной для человечества».

Исследование опубликовано в Journal of Artificial Intelligence Research.

Предыдущая версия этой статьи впервые была опубликована в январе 2021 года. .