Искусственный интеллект теперь достаточно умен, чтобы знать, когда ему нельзя доверять

Как мог бы «Терминатор» разыграться, если бы Скайнет решил, что он, вероятно, недостаточно ответственен, чтобы держать ключи от всего ядерного арсенала США? Как выясняется, ученые просто спасли нас от будущего апокалипсиса под руководством ИИ, создав нейронные сети, которые знают, когда они ненадежны.

Нейронные сети с глубоким обучением предназначены для имитации человеческого мозга, изучая множество факторов, выявляя закономерности в массах данных, которые люди не в состоянии проанализировать.

Хотя до Скайнета еще далеко, ИИ уже принимает решения в областях, которые влияют на жизнь людей, таких как автономное вождение и медицинская диагностика, а это означает, что жизненно важно, чтобы они были как можно более точными. Чтобы помочь в достижении этой цели, эта недавно созданная система нейронных сетей может генерировать свой уровень уверенности, а также свои прогнозы.

«Нам нужна способность не только обладать высокопроизводительными моделями, но и понимать, когда мы не можем доверять этим моделям», — говорит ученый Александр Амини из Лаборатории компьютерных наук и искусственного интеллекта Массачусетского технологического института (CSAIL).

Это самосознание надежности получило название глубокой доказательной регрессии, и оно основывает свои оценки на качестве доступных данных, с которыми оно должно работать — чем точнее и полнее обучающие данные, тем более вероятно, что будущие прогнозы сработают.

Исследовательская группа сравнивает это с беспилотным автомобилем, имеющим разные уровни уверенности в том, следует ли проехать через перекресток или подождать, на всякий случай, если нейронная сеть менее уверена в своих прогнозах. Рейтинг достоверности даже включает советы по повышению рейтинга (например, путем настройки сети или входных данных).

Хотя аналогичные меры безопасности были встроены в нейронные сети и раньше, то, что отличает эту систему от других, — это скорость, с которой она работает, без чрезмерных вычислительных затрат — ее можно выполнить за один проход по сети, а не за несколько, с уровнем достоверности, выводимым одновременно с решением.

«Эта идея важна и широко применима, — говорит ученый Даниэла Рус. «Ее можно использовать для оценки продуктов, основанных на изученных моделях. Оценивая неопределенность изученной модели, мы также узнаем, сколько ошибок следует ожидать от модели и какие недостающие данные могут улучшить модель».

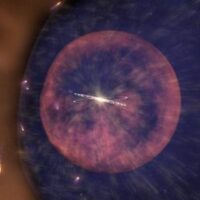

Исследователи протестировали свою новую систему, заставив ее определять глубину в разных частях изображения, так же как беспилотный автомобиль может определять расстояние. Сеть хорошо сравнивалась с существующими установками, а также оценивала свою собственную неопределенность — когда она была наименее уверенной, действительно были случаями, когда она ошибалась.

В качестве дополнительного бонуса сеть могла отмечать случаи, когда она сталкивалась с изображениями за пределами своей обычной компетенции (которые сильно отличаются от данных, на которых она была обучена).

Даже если нейронная сеть работает в 99% случаев, упущенный 1% может иметь серьезные последствия, в зависимости от сценария. Исследователи говорят, что уверены, что их новый оптимизированный тест доверия может помочь повысить безопасность в режиме реального времени, хотя работа еще не прошла экспертную оценку.

«Мы начинаем видеть, как все больше этих [нейросетевых] моделей просачиваются из исследовательской лаборатории в реальный мир в ситуациях, затрагивающих людей с потенциально опасными для жизни последствиями», — говорит Амини.

«Любой пользователь метода, будь то врач или человек на пассажирском сиденье транспортного средства, должен знать о любом риске или неопределенности, связанной с этим решением».

Исследование будет представлено на конференции NeurIPS в декабре, и доступно онлайн.