ИИ может объяснить, почему мы не встречаем инопланетян, предполагает дикое исследование

Искусственный интеллект проявляется тысячами различных способов. Это помогает ученым разобраться в огромных массивах данных; это помогает обнаружить финансовое мошенничество; он водит наши машины; он предлагает нам музыку; его чат-боты сводят нас с ума. И это только начало.

Способны ли мы понять, насколько быстро ИИ будет продолжать развиваться? А если ответ отрицательный, то является ли это Великим фильтром?

Парадокс Ферми — это несоответствие между кажущейся высокой вероятностью существования развитых цивилизаций и полным отсутствием доказательств их существования. Было предложено множество решений, объясняющих, почему существует несоответствие. Одной из идей является «Великий фильтр».

Великий фильтр — это гипотетическое событие или ситуация, которая не позволяет разумной жизни стать межпланетной и межзвездной и даже приводит к ее гибели. Подумайте об изменении климата, ядерной войне, ударах астероидов, взрывах сверхновых, эпидемиях и многих других событиях из галереи мошеннических катастрофических событий.

А как насчет быстрого развития искусственного интеллекта?

Новая статья в Acta Astronautica исследует идею о том, что искусственный интеллект становится искусственным сверхинтеллектом (ИСИ) и что ИСИ — это Великий фильтр. Название статьи: «Является ли искусственный интеллект великим фильтром, который делает развитые технические цивилизации редкими во Вселенной?» Автор — Майкл Гарретт с факультета физики и астрономии Манчестерского университета.

«Без практического регулирования есть все основания полагать, что ИИ может представлять серьезную угрозу для человечества. будущий курс не только нашей технической цивилизации, но и всех технических цивилизаций».

Майкл Гарретт, Манчестерский университет

Некоторые думают, что Великий фильтр предотвращает технологические виды, подобные нашему, не станут многопланетными. Это плохо, потому что вид подвергается большему риску исчезновения или застоя, имея только один дом. По словам Гарретта, вид участвует в гонке со временем без резервной планеты.

«Предполагается, что такой фильтр появится до того, как эти цивилизации смогут развить стабильное многопланетное существование, что предполагает типичное долголетие. (L) технической цивилизации менее 200 лет», — пишет Гарретт.

Если это правда, то это может объяснить, почему мы не обнаруживаем техносигнатур или других свидетельств внеземного разума (внеземного разума). О чем это нам говорит? о нашей собственной технологической траектории? Если мы столкнемся с 200-летним ограничением, и если это из-за ИСИ, что это нас оставит?

Гарретт подчеркивает «…острую необходимость быстрого создания нормативной базы для развития ИИ на Земле и продвижения многопланетное общество, чтобы смягчить такие экзистенциальные угрозы».

Многие ученые и другие мыслители говорят, что мы находимся на пороге огромной трансформации. ИИ только начинает менять то, как мы действуем; большая часть преобразований остается за кулисами. Искусственный интеллект, похоже, готов ликвидировать рабочие места для миллионов людей, а в сочетании с робототехникой трансформация кажется практически безграничной. Это довольно очевидная проблема.

Но существуют более глубокие и систематические проблемы. Кто пишет алгоритмы? Будет ли ИИ каким-то образом дискриминировать? Почти наверняка. Подрывают ли конкурирующие алгоритмы могущественные демократические общества? Останутся ли открытые общества открытыми? Начнёт ли ИСИ принимать решения за нас, и кто будет нести ответственность, если это произойдет?

Это расширяющееся дерево ветвящихся вопросов без четкого конца.

Стивен Хокинг (RIP), как известно, предупредил, что ИИ может положить конец человечеству, если оно начнет развиваться самостоятельно.

«Я боюсь, что ИИ может полностью заменить людей. Если люди будут создавать компьютерные вирусы, кто-то создаст ИИ, который будет улучшаться и воспроизводить себя. Это будет новая форма жизни, которая превосходит людей», — сказал он журналу Wired в 2017 году. Как только ИИ сможет превзойти людей, он станет ИСИ.

Хокинг, возможно, один из самых узнаваемых голосов, предупреждающих об ИИ, но он далеко не единственный. Средства массовой информации полны дискуссий и предупреждений, а также статей о работе искусственного интеллекта для нас. Самые тревожные предупреждения говорят о том, что ASI может выйти из строя. Некоторые люди считают это научной фантастикой, но только не Гарретт.

«Обеспокоенность по поводу того, что искусственный сверхинтеллект (ИСИ) в конечном итоге выйдет из-под контроля, считается серьезной проблемой. Борьба с этой возможностью в течение следующих нескольких лет является растущим исследовательским направлением для лидеры в этой области», — пишет Гарретт.

Если бы ИИ не давал никаких преимуществ, проблема была бы намного проще. Но это дает всевозможные преимущества: от улучшения медицинской визуализации и диагностики до более безопасных транспортных систем. Задача правительств заключается в том, чтобы позволить процветать выгодам и одновременно ограничивать ущерб.

«Это особенно актуально в таких областях, как национальная безопасность и оборона, где ответственное и этическое развитие должно иметь первостепенное значение», — пишет Гарретт.

Проблема в том, что мы и наши правительства не готовы. Никогда не существовало ничего подобного ИИ, и как бы мы ни пытались концептуализировать его и понять его траекторию, мы все равно ничего не добились.

И если мы находимся в таком положении, то же самое произойдет и с любым другим биологическим видом, который разрабатывает ИИ. Появление ИИ, а затем и ИСИ может быть универсальным, что делает его кандидатом на роль Великого Фильтра.

Это риск, который представляет ИСИ в конкретных терминах: ему больше не нужна биологическая жизнь, которая его создала.

«Достигнув технологической сингулярности, системы ИСИ быстро превзойдут биологический интеллект и будут развиваться со скоростью, которая полностью опережает традиционные механизмы надзора, что приведет к непредвиденным и непредвиденным последствиям, которые вряд ли будут соответствовать биологическим интересам или этике, — объясняет Гарретт.

Как мог ИСИ освободиться от надоедливой биологической жизни, которая его загнала в загон? Он может создать смертельный вирус, он может препятствовать производству и распределению сельскохозяйственных продуктов питания, он может привести к расплавлению атомной электростанции и может начать войны.

Мы на самом деле не знаем, потому что все это неизведано. территория. Сотни лет назад картографы рисовали монстров в неизведанных регионах мира, и именно этим мы и занимаемся сейчас.

Если все это звучит печально и неизбежно, Гаррет говорит, что это не так.

Если все это звучит печально и неизбежно, Гаррет говорит, что это не так.

Если все это звучит печально и неизбежно, Гаррет говорит, что это не так.

Если все это звучит печально и неизбежно.

p>

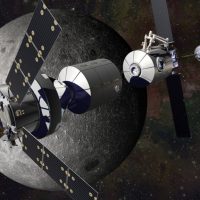

Его анализ до сих пор основан на ИСИ и людях, занимающих одно и то же пространство. Но если мы сможем достичь многопланетного статуса, перспективы изменятся.

«Например, многопланетный биологический вид мог бы воспользоваться независимым опытом на разных планетах, диверсифицируя свои стратегии выживания и, возможно, избегая единственного -точечный отказ, с которым сталкивается планетарная цивилизация», — пишет Гарретт.

Если мы сможем распределить риск между несколькими планетами вокруг нескольких звезд, мы сможем защитить себя от наихудших возможных последствий ИСИ.

>

«Эта распределенная модель существования повышает устойчивость биологической цивилизации к катастрофам, вызванным искусственным интеллектом, создавая избыточность», — пишет он.

Если одна из планет или аванпостов, которые займут будущие люди, не сможет переживут технологическую сингулярность ASI, другие смогут выжить. И они извлекут из этого урок.

Мультипланетный статус может даже дать больше, чем просто выжить в ИСИ. Это могло бы помочь нам освоить его. Гарретт представляет себе ситуации, в которых мы можем более тщательно экспериментировать с ИИ, сохраняя при этом его сдерживание. Представьте себе ИИ на изолированном астероиде или карликовой планете, выполняющий наши приказы без доступа к ресурсам, необходимым для побега из тюрьмы.

«Это позволяет создавать изолированные среды, в которых эффекты продвинутого ИИ можно изучать без непосредственного риска. глобального уничтожения», — пишет Гарретт.

Но вот в чем загадка. Развитие искусственного интеллекта идет ускоренными темпами, в то время как наши попытки стать многопланетными — нет.

«Несоответствие между быстрым развитием искусственного интеллекта и более медленным прогрессом космических технологий огромно», — пишет Гарретт. .

Разница в том, что искусственный интеллект является вычислительным и информационным, но космические путешествия сопряжены с множеством физических препятствий, которые мы пока не знаем, как преодолеть. Наша собственная биологическая природа ограничивает космические путешествия, но никакое такое препятствие не ограничивает ИИ.

«Хотя ИИ теоретически может улучшать свои возможности почти без физических ограничений, — пишет Гарретт, — космические путешествия должны сталкиваться с энергетическими ограничениями, материальными границы науки и суровые реалии космической среды».

На данный момент ИИ действует в рамках установленных нами ограничений. Но это не всегда так. Мы не знаем, когда ИИ может стать ИСИ и вообще сможет ли он это сделать. Но мы не можем игнорировать такую возможность. Это приводит к двум взаимосвязанным выводам.

Если Гарретт прав, человечество должно более усердно работать над космическими путешествиями. Это может показаться надуманным, но знающие люди знают, что это правда: Земля не будет пригодна для жизни навсегда. Человечество погибнет здесь от нашей собственной руки или от руки природы, если мы не расширимся в космос. Оценка Гарретта на 200 лет просто ставит здесь восклицательный знак. Возобновление акцента на достижение Луны и Марса вселяет некоторую надежду.

Второй вывод касается законодательства и управления ИИ, что является сложной задачей в мире, где психопаты могут получить контроль над целыми нациями и стремятся вести войну.

«Хотя заинтересованные стороны отрасли, политики, отдельные эксперты и их правительства уже предупреждают о необходимости регулирования, создание нормативной базы, которая могла бы быть приемлемой во всем мире, будет сложной задачей», — пишет Гарретт.

Сложность едва ли описывает это. Междоусобные раздоры человечества делают все это еще более неуправляемым. Кроме того, как бы быстро мы ни разрабатывали руководящие принципы, ИСИ может измениться еще быстрее.

«Без практического регулирования есть все основания полагать, что ИИ может представлять собой серьезную угрозу будущему курсу не только нашей техническая цивилизация, но все технические цивилизации», — пишет Гарретт.

Если мы это сделаем, это может свестись к тому, что может показаться скучным и обыденным: спорам по поводу законодательства.

«Настойчивость разумных людей и сознательная жизнь во Вселенной может зависеть от своевременного и эффективного внедрения таких международных нормативных мер и технологических усилий», — пишет Гарретт.

Эта статья была первоначально опубликована Universe Today. Прочтите оригинал статьи.